中華民國113年6月出刊

人工智慧(Artificial Intelligence, AI)發展席捲全球,透過機器學習、大數據等技術的交互運用,提供企業多種數位轉型的可能性,產業間也發展出新的合作模式與服務樣態。然而,在企業內部導入AI模型,或與供應商之技術合作將對現行規範造成一定程度之衝擊。目前電信或通傳業務中AI技術之應用趨勢將對通傳市場帶來何種影響?通訊傳播法規是否相對應地存在調適之需求?

基此,本文蒐整國際與我國通訊傳播業者運用AI技術之相關案例以及主要國家AI法制發展,進一步歸納AI治理及法規調適趨勢,研析未來通訊傳播領域潛在之法制議題,以供我國借鏡。

AI泛指透過機器學習與演算法,模擬人類進行決策的模組或技術,依據不同的演算邏輯構成AI模型,其架構多以雲端平臺與資料庫做為AI模型的演算基礎,或連接無線通訊設備與感測器等蒐集資料數據,做為訓練AI的來源。透過AI整合智慧裝置,可實現作業系統的半自動化(automation)或全自動化作業處理,為製造、醫療、通訊傳播、汽車、國防、航空等領域創造附加價值。

以2022年OpenAI發表的ChatGPT為例,其被稱為生成式AI(Generative AI, GAI or GenAI),不同於過往僅能依據特定資料輸入,執行特定任務輸出的弱人工智慧,GAI係由基礎模型(foundation model)使用未標記的訓練資料透過下指令(prompt)自動輸出內容。現在AI模型朝向可交互生成語言、語音、圖像及視覺資料等整合性資料的方向發展,可預期其應用層面將逐漸擴展至各種不同的生活領域。

隨著第五代行動通訊(5G)、物聯網(Internet of Things, IoT)及衛星通訊技術演進,通訊網路正朝向技術共存、混合型且分散的部署架構方向發展,而第六代行動通訊(6G)技術標準已納入原生AI(native AI)應用考量。當各種通訊頻段、大量且不同類型的終端裝置紛紛出現,市場有關邊緣運算(edge computing)的需求亦日益擴大,電信網路營運的複雜性逐漸增加,網路更需因應不同產業垂直領域業者的新需求,進行基於服務(service based)的效能增強與優化。目前可觀察通傳產業將AI運用於營運管理及服務體驗兩個層面的發展,略述如下:

因應網路整合的需求不斷地提升,傳統依靠人力調整技術參數之作法已有不足,電信業者可利用AI來提升既有核心網路與無線接取網路(Radio Access Network,RAN)之效率。核心網路除採用AI/ML於用戶的專用管理與資料流外,因應近年網路架構變遷趨勢,亦可針對核心網路節點或AI核心應用場景進行特定的事件與資料管理。RAN則可透過AI/ML取代部分基於特定規則的軟體,用以處理部分關鍵的通訊功能,例如選擇通訊通道的編碼模組,或控制波束成型。

尤其在近年強調節能減碳與永續發展的數位轉型浪潮下,AI/ML解決方案可持續提升網路資源的使用效率,協助電信業者達到永續淨零目標,例如我國電信業者利用AI分析用戶量、網路負載、頻譜效率及基站位置等數據,以最佳化網路資源之分配及利用。進一步者,業者可透過AI進行網路效能、故障管理與預防性維護分析,或強化服務水準協議(Service Level Agreement, SLA)管理、客戶關係與產品性能之監控、預測,以及降低用戶流失。

電商、行銷規劃、智能客服處理更是AI擅長的領域,從早期的ML結合NLP技術的對話式AI(Conversational AI),到如今以大型語言模型(LLM)與GAI優化智能客服功能,強化對用戶語境感知與持續學習力,進而協助稽核與情緒分析、改善用戶抱怨、提升用戶回應速度等,均有效提升用戶的服務體驗。我國電信業者已有與國外業者合作,發展AI無人智慧客服系統,用戶可在更具智慧的服務平臺上,獲得即時的客戶服務互動。

除核心的通訊服務外,AI在電子商務、OTT影音服務及數位行銷上,透過數位平臺結合AI運算能力,分析各種用戶資料、瀏覽紀錄等,以打造個人化服務。數位平臺端可用GAI強化既有的用戶訊息推播與搜尋功能,達到精準行銷目的。

我國通傳業者目前在AI的應用上,多是以改進內部營運效能優化與客服體驗為主,例如電信領域中涉及個人資料、專業判斷的業務,通訊流量分析涉及使用地點、裝置資訊等流量數據,原則上經過去識別化處理。

在傳播領域方面,國外已出現新聞媒體等數位內容產製領域的AI應用,例如AI代理人播報新聞。這些「代理人」的GAI技術應用,亦建立於人為監督的特定資料庫並配合LLM學習,以提升回應的準確率及混合式應用架構。傳播領域的AI技術應用演進脈絡與通訊領域相仿,早期AI人工監督的程度尚高,扮演輔助媒體編輯室的角色;現在有GAI的協助,只需結合對應圖像、語音等資料庫建立模型,即可直接產生或轉譯新聞稿及影音內容。

在影視製作中,GAI可協助快速地生成影像、加強後製作業如字幕生成等;數位娛樂產業可透過AIGC技術與AI的語音合成轉譯技術,產生與真人更接近的「虛擬人」,應用包括AI虛擬主播、虛擬助理,依據用戶調整互動體驗,達到實質感知環境後進行決策的全能代理人(agent)效果。當大型多模態模型(LMM)發展突破現階段技術整合的挑戰逐漸擴大規模,AI內容的生成樣態將更為擬真與多元。未來通傳領域業者將持續向企業客戶拓展新業務以創造新收益,隨著GAI的成熟普及,涉及內容產製的產業生態也將逐漸受到影響。

在AI應用拓及社會各層面時,AI模型需要的「算力」直接提升底層雲端基礎設施的重要性,AI晶片的發展預期將帶動半導體、智慧終端、硬體設備的開發及技術導入。2024年世界行動通訊大會(Mobile World Congress2024, MWC2024)主題即為GAI於垂直場域應用落地元年,AI生態系逐漸成形。全球電信商如T-Mobile、阿聯酋電信、新加坡電信(Singtel)、軟銀電信(Softbank)與韓國電信(SKT)於展會期間亦組成「全球電信AI聯盟」(Global Telco AI Alliance, GTAA);網通、雲端服務業者如Arm、AWS也成立AI-RAN聯盟,促進GAI產業鏈發展。由電信業者間在AI應用的聯盟或合作觀察可知,未來業者間的競爭與合作關係將更加的複雜,AI發展對於通傳產業之影響,也將從個別業者的服務優化或資源效率提升,逐漸進展成為產業合作或取得競爭優勢的關鍵因素。

各國在推動AI產業創新之同時,也逐漸面臨各種社會層面的影響議題。歐盟首先於2023年推動「人工智慧法案」(Artificial Intelligence Act, AIA),法案明訂禁止使用人工智慧的用途,建立基於風險(risk-based)的監管框架與對高風險人工智慧系統(High Risk Artificial Intelligence System, HRAIS)的程序要求;同年11月,歐盟與英國、美國、加拿大、新加坡、日本、韓國、澳洲、巴西等28個國家簽署「布萊切利宣言」(Bletchley Declaration),聚焦討論包含LLM在內、具廣泛目的(general-purpose)、可執行多種任務的前沿AI(frontier AI)所帶來之潛在風險與安全開發之國際共識,倡議國際合作,連帶影響各國對AI治理政策與法規調適之探討,諸多國際評論均認為2024年為國際AI監管發展的競賽年。

基此,本文以「布萊切利宣言」之主要國家為研究標的,延伸蒐集近期與通傳領域相關之AI應用法規調適案例,歸納通傳產業AI應用之重點議題。

各國政府在AI治理上,多已制訂出整體的AI政策目標,建立最上層的AI倫理準則,再建立利於產業導入AI技術的共通性指引。因應產業創新推動與人民基本權益維護,優先考量如「倫理」、「資訊安全」、「隱私與個人資料管理」、「透明與可歸責性」,強調AI系統之可信任(trustworthy)、強健(robust),得以發揮普惠(inclusive)價值。例如新加坡,其首先藉由AI於金融產業之應用狀況,制定原則與技術規範並導入經驗,而後逐漸形塑國家AI政策;2021年新加坡即以「國家財政計畫」與「國家政府計畫」為其AI政策定調,係以AI促進國家數位轉型為主軸,並整合財政部門AI能力,強化風險管理、客戶服務與商業競爭力。

相較於歐盟已針對AI進行立法,美國、新加坡、英國等尚未以法強制規範AI,僅在管制方式、強度與規範主體上,建立基於風險的管理框架,提供產業發展AI有所依循。例如美國商務部轄下國家標準與技術研究院(National Institute of Standards and Technology, NIST)建立的「人工智慧風險管理框架1.0」(Artificial Intelligence Risk Management Framework, AI RMF1.0),鼓勵企業自願遵循。新加坡採取與NIST AI RMF1.0對應的治理框架AI Verify,配合由政府機關聯合開發的AI檢測最小化產品(Minimum Viable Product, MVP),促使企業透過實際檢測流程強化企業與利害關係人的AI透明度。

英國對AI技術治理之認知則是基於情境(context based)的,並明確於2023年「支援創新之AI監理作法白皮書」(A pro-innovation approach to AI regulation)中採取「創新迭代」(innovative and iterative)治理方法,說明其不傾向創造新的AI法或成立監管單位,而是基於既有部門規範進行AI治理。故在管理架構調整上,擬由各單位透過新設立的中央AI職能(central AI function),以及各行政單位設立的首席AI長(lead chief AI),強化跨部門的溝通協調。

目前以專法管制AI的治理模式以歐盟最具代表性,透過框架式立法要求企業導入AI系統前或開發前之測試與稽核要求,以及風險之識別與衝擊評估等。部分國家如巴西、加拿大與韓國亦有仿效歐盟訂定AI專法草案、提高管制強度。例如加拿大於2022年提出的「人工智慧資料法草案」(Artificial Intelligence and Data Act, AIDA),係屬於「數位憲章實施法」(Digital Charter Implementation Act, Bill C-27)的一部分,AIDA特別針對所有實施與AI系統相關、跨州、跨國商業行為之企業體,制定資料管理、實施衝擊評估及紀錄保存等合規措施,其中包括需公開揭露高風險AI系統。依據AIDA,執法單位有權針對涉及於稽核期間提供錯誤資訊,或使用AI系統之不法行為進行裁罰;並於C-27推動同時,將於既有的消費者保護、人權、刑法、藥品及銀行法律框架中,納入人工智慧應用規範。

綜覽主要國家AI技術應用的規範主體,主要可分為具有明確特定用途之AI系統風險層級管制者,如歐盟;以及將高風險程度列為考量因素之AI應用者,如加拿大、美國及英國。

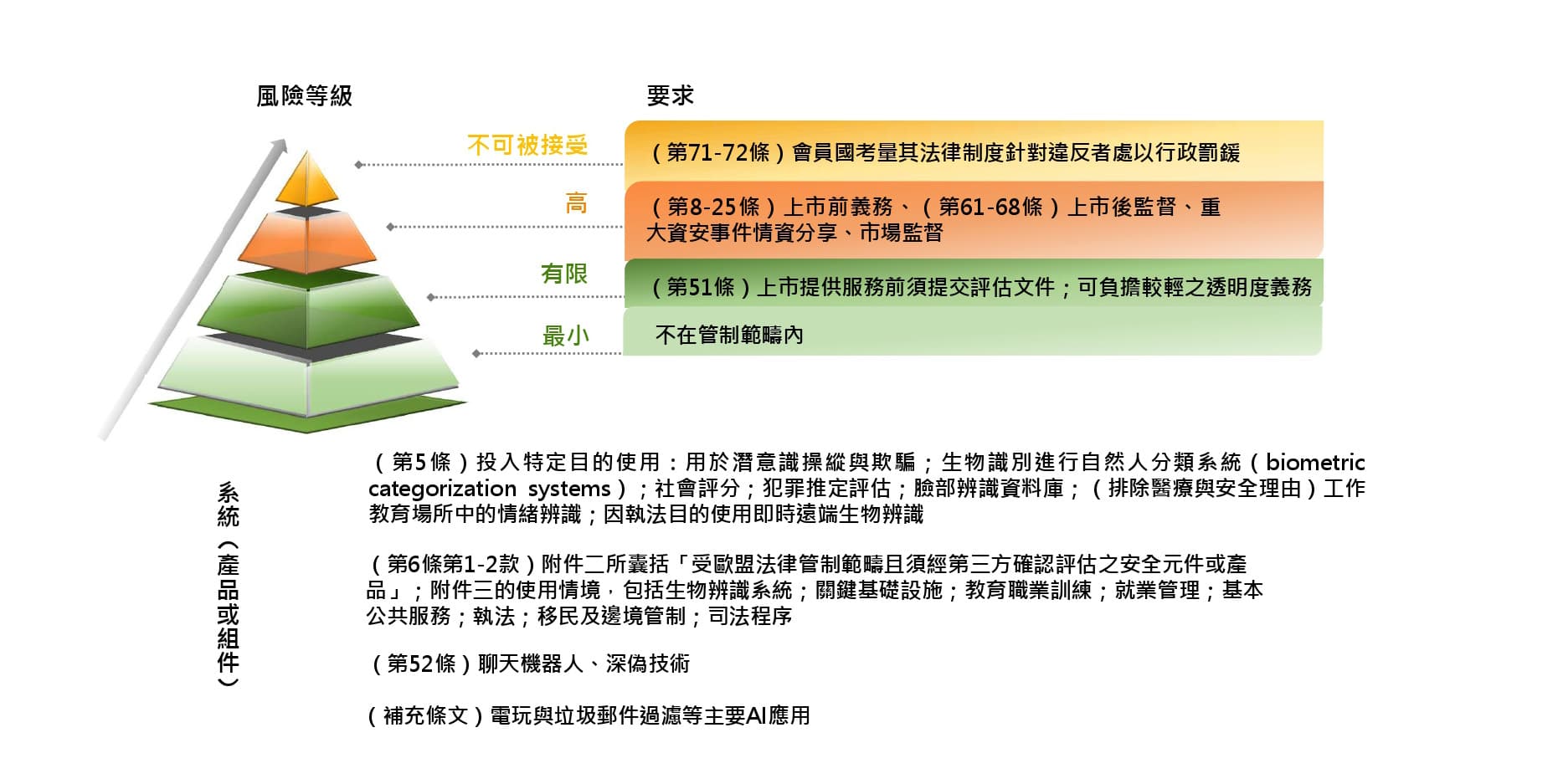

歐盟的AIA中將「商用AI系統」分為4個風險等級,包括不可被接受(unacceptable)、高風險(high risk)、有限風險(limited risk)與最小風險(minimal risk)。其分類準則為不對自然人的健康、安全或基本權利構成重大損害風險,以及不會對決策結果產生重大影響。除最小風險者不受AIA規範,其餘均須負擔不同透明度要求與義務;高風險與有限風險者則須於進入市場前提交評估證明,且高風險者在上市前須註冊登記於歐盟高風險資料庫並對外公開。

2024年版的AIA已專章訂定通用目的AI(General purpose AI, GPAI)系統之透明度義務與深偽(deep fake)技術規範,GPAI係獨立於AI系統之風險分類層級。當GPAI被認定為具高影響力者,須負擔特定透明度義務,而在使用深偽技術或聊天機器人時,須符合有限風險之揭露要件。其規範對象包括AI系統的開發者(developer)、部署者(deployer)、分銷商(distributer)與產品製造商(product manufacturer)之義務,同時建構預防配套措施,包括修訂「產品責任指令」(Proposed amendments to Product Liability Directive, PLD)與「人工智慧責任指令」(Artificial Intelligence Liability Directive, AILD)。

資料來源:本研究整理(AIA, Consolidate text)

有別於歐盟的風險管理,加拿大的AIDA(草案)雖未定義何謂高風險AI系統,但以「基於健康、安全造成之風險損害及人權、偏見」等因素,規範具高影響力的AI(high influence AI)系統,要求企業對高影響力系統的「設計、開發、使用、管理系統操作」,採取全生命週期的風險控制與緩解措施。被認定為具潛在影響力者,包括影響服務就業篩檢、依生物辨識推理與識別、大規模影響人類身心(例如線上推薦系統)、攸關健康安全(例如自動駕駛或衛生部門分流決策)之系統。

同樣地,美國於NIST的RMF1.0框架建立宗旨即表明,AI將因技術與社會因素(social-technical),例如AI系統如何被使用、與其他AI系統互動、誰來操作及社會脈絡,產生不同程度的風險與利益,故風險框架僅列出AI對人類、組織或生態系統最小程度之可能危害,實際由個人或企業組織自願性地依治理(Govern)、路徑(map)、測量(measure)、管理(manage)面向評估其風險。在此思維基礎下,美國將風險程度的判定歸於既有聯邦組織體系,2023年總統拜登「基於安全、可靠、值得信賴的人工智慧」行政命令(Executive Order on the Safe,Secure, and Trustworthy Development and Use of Artificial Intelligence)指出可能危害全國人民福祉之系統風險,要求商務部、國土安全領域相關聯邦單位特別針對國安、資安具潛在危害風險的雙用途基礎模型(dual-use foundation model),訂定相關指引並研議治理措施。

英國對AI的風險定義可見於2024年對前揭AI白皮書相關意見徵求結果的回應聲明,具社會危害(societal harms)、濫用(misuse)和自主(autonomy)的風險,係源自於2023年AI高峰會(AI summit)針對前沿AI發展的討論結果,但並未定義特定AI系統的風險程度,僅將AI分為通用目的AI(general purpose AI)、高度運作AI(highly capable narrow AI)與AI代理(agent AI)三個項目,不難發現對於AI規範的要求,係根據人工智慧技術發展是否接近人類認知及決策程度而加以分類。

由上述各國AI管制發展可觀察到,針對AI之產業應用,主要國家以建立AI倫理框架為先,釐清權利保障原則,將包括生物辨識技術、深偽技術及聊天機器人在內的AI系統,納入風險管理主體。再者,針對AI產業市場參進者,包括AI技術供應者及使用AI技術提供服務者,則以政策或法制逐步提出監督義務。部分國家如加拿大、巴西、韓國已打算效仿歐盟作法,訂定AI專法管制,對使用AI之不法行為提出相應罰則,做為事後究責依據。

現階段在通傳領域較為直接的法制政策發展上,以中國針對特定AI技術(深度合成、生成式AI)之行政管理辦法或措施,與通傳產業較為相關,例如「互聯網信息服務(網際網路資訊服務)深度合成規定」及「生成式AI服務管理暫時性辦法」,其他則較少專門針對通傳領域規範。然而,通訊傳播產業身為資訊流通的重要管道,流通速度或觸及範圍皆為無遠弗屆,故時常也被期待成為內容流通之守門人,負有一定的管理義務。

深偽技術管制發展較早,2019年已有國家針對深偽技術的非法應用與非法傳播建立罰則,包括助長色情或性暴力等非法內容所造成的權力損害。

針對色情內容可能觸及的兒少保護及網路治理議題,2019年美國包括加州及德州立法禁止未經同意製作的色情深度偽造,2021年韓國亦修正2019年的「性暴力犯罪之相關特例法」,除原先禁止使用深偽技術製作虛假影像等數位性暴力行為,更將散布虛偽影像與藉機營利者納入刑罰。2023年美國路易斯安那州通過參議院法案,取締利用AI生成兒童性虐待(sexual abuse)的深度偽造內容,並將數位平臺使用者未經同意即傳播及銷售相關色情內容等作為列入刑罰。

英國則將深偽內容納入數位平臺規範並訂定相關供應商義務。2022年英國宣布將深偽技術管制納入「線上安全法案」(Online Safety Bill)中,所有受管制的「使用者對使用者服務」(user-to-user service)提供者均需針對「非法內容」進行風險評估。此外,需確保服務條款中具體說明保護個人免於受非法內容侵害等義務,以及在服務設計或營運中涉及行為識別(behavior identification)之主動技術(proactive technology)運用,使用人工智慧或機器學習分析相關內容之資訊中,應加以說明成人使用者與生成內容兩者間互動之控制措施。Ofcom基於職責監督數位平臺業者處理詐騙與提高線上服務安全,2023年公布數位平臺準則,針對中、高風險服務提供自動關鍵字搜尋偵測詐騙資訊,以及帳號認證等建議措施,預計於2024年公布其他類型服務之準則。

有鑑於使用GAI技術的非法電話詐騙與不實訊息傳播日益猖獗,造成民眾實質損害與困擾,美國FCC為確保消費者免於遭受非法機器人詐騙,於2023年11月針對非法語音電話發起意見徵求(Notice of Inquiry),並於2024年2月發布宣告性裁決(Declaratory Ruling),根據「電話消費者保護法」(Telephone Consumer Protection, TCPA)將其視為非法行為。非法機器人詐騙包括以生成語音或文字訊息模仿人類演說,並與消費者進行互動的語音電話(robocalling)及自動回覆訊息(robotexting),特定的AI技術如聲音仿製(voice cloning),將列入TCPA現行禁止的「未經收話方明確同意接受人工或預錄語音訊息」(artificial or prerecorded voice messages)範疇。

在TCPA的規範下,人工或預錄語音訊息於發送前,須獲得受話方的同意、提供特定識別與資訊揭露,若涉及電話行銷者,需提供受話方退出通話及要求禁止撥打其電話號碼之權力。而聯邦交易委員會(Federal Trade Commission, FTC)與聯邦選舉委員會(Federal Election Commission, FEC)也分別透過寄送警告給閘道器(gateway)供應商,進行多重網路管制,以有效減少非法國際機器人電話。FCC警告供應商若未能防止其網路傳輸巨量的非法流量,將要求下游供應商阻斷或停止接收其流量。

韓國通訊傳播委員會(Korea Communications Commission,KCC)於2023年7月針對最大搜尋引擎與入口網站營運商NAVER是否違反「電信事業法」(전기통신사업법),進行事實查核,該法第42條及第50條規定明文禁止,對利用電信服務提供其他服務者施以不公平、不合理或具歧視性的條件與限制。而NAVER運用演算法並根據使用者消費模式,推薦推薦特定新聞曝光的服務,以及運用指標數據特意凸顯或弱化特定媒體公司之作法,可能被視為不公平歧視或施以不公平之條件與限制。其中主要爭議點來自於「新聞演算法」可能形成偏誤的主因,恐導致對特定媒體的歧視與公眾意見的扭曲,若查核確認屬於違規,KCC將對NAVER處以罰款並提起刑事訴訟。

據韓國媒體報導指出,韓國第二大入口網站營運商Daum針對新聞評論區留言採行過濾機制,引發國會討論是否有政治偏誤疑慮。自2020年起Daum使用AI機器人SafeBot偵測並屏蔽髒話與粗鄙言論,引發關注的問題在於使用資料標記方法訓練AI模型的過程,以及仇恨言論的模糊判斷標準與平臺審查責任;爭議之處在於是否公開演算法或將演算法視為商業機密,以及不同新聞平臺使用不同的AI模型,是否造成仇恨言論在歸類上的差異。

美國紐約時報於2023年對ChatGPT開發公司Open AI與Microsoft提起訴訟,因其非法複製及使用該報刊登之線上內容,做為支持GPT的LLM訓練內容;而Microsoft的搜尋引擎Bing Chat未經允許將其內容摘要、擴寫之行為,已嚴重損害該報與其客戶之關係。紐約時報宣稱GAI產品已嚴重威脅高品質新聞產製,分別主張OpenAI與Microsoft藉由廣泛的內容侵權、對其產品的商業剝削/傳散與再製行為,獲取巨大利益,且因AI幻覺(hallucination)錯置內容造成損害。OpenAI則於2024年1月發表聲明反駁其訴訟主張,認為公開的網路媒體內實屬「合理使用範圍」,內容原樣輸出(Regurgitation)係為系統的罕見錯誤,且表明其已於雙方談判中旋即取消造成錯誤的功能,但仍願意與新聞業保持合作。此案仍在訴訟階段,顯示隨著生成技術成熟,對生成內容的著作權主體與智慧財產權爭議,將被重新帶上檯面。

從技術演進與應用案例而論,國際AI技術成熟應用者已從弱人工智慧系統發展至LLM等通用型人工智慧,逐漸商品化。當AI技術成為產品,對於各領域利害關係人(包含商業利益)之基本保障,構成監管機構規範之主要目的,故目前AI法制均以個人權益與技術發展公平性為最核心的目標制定倫理準則,並訂定如風險管理、個資、資安等共通性需求或技術標準,以輔助企業落實,其中歐盟亦於法制上納入監理沙盒(Regulatory Sandbox)規定,避免因監管限制技術創新應用。

由於AI技術應用已打破行業別限制,AI監理主流的趨勢從早期的領域「自律」,逐漸因歐盟AIA朝「他律」方向發展整體的監管專法,且多著墨於事前(ex-ante)監管之作法,亦著墨於大型數位平臺等潛在數位市場主導者之競爭規範。有別於歐盟的全面監管專法模式,美國、英國在個別領域的規範重點上,則多以應用領域之情境為主,進行部門權責內之法規調適,目前主要國家認定之關鍵應用領域多涉及醫療、教育、就業、交通等高風險領域。

我國數位發展部數位產業署參考歐盟AIA作法,於民國113年3月公布「人工智慧(AI)產品與系統評測參考指引」草案;國家科學及技術委員會亦規劃制定AI基本法,欲透過基本立法,規劃智慧金融、醫療領域之部門法規,如何整合該會、金融監督管理委員會及衛生福利部既有行政規則,做為我國法規調適主軸,將是未來努力的方向。

回顧我國電信與傳播產業之AI技術應用,電信產業初期集中於優化既有業務的範疇,包括透過自然語言處理客服業務等LLM開源技術建立模型,應可認定為非「以AI做為產品或元件」者。另一方面,我國電信產業近年利用AI軟、硬體及平臺解決方案提升網路營運效率,以達成永續目標,若將兩者置於歐盟AIA,其應屬「大宗的AI應用」(a majority of AI application),具最小風險。值得注意的是,當AI系統做為「關鍵基礎設施」(Critical Infrastructure, CI)之安全元件(safety components),或做為輔助業者及消費者決策之系統,例如用戶使用行為分析、提供推薦服務等加值業務,以及GAI與LLM技術的自主開發,則可能被視為高風險或有限風險的範疇。

國際傳播領域現階段因GAI結合ML的深偽技術,造成不實訊息或不當內容傳散之問題,已引發經濟或政治層面的實質損害,對於AI技術開發、AI服務供應商與內容產製業者而言,新聞產業之競爭合作關係仍存在。再者,我國針對數位內容及數位平臺採取政府與企業的「共律」模式,不及韓國KCC監理非法內容之力度,為因應內容再製技術的進步,以及非法內容生成數量與生成速度的日益增長,所涉及的資料合法使用及治理議題,仍需重新檢視是否有訂定相關行政規範之必要性。

由以上觀察分析可知,未來電信及傳播領域的共通議題,將是企業自主開發的「演算法」,是否在某特定電信業務情境下,被認定為無正當理由並以先進或優勢技術,對其他市場參進者構成不公平競爭,這涉及我國AI法制規範主體是否囊括應用行為或底層的技術邏輯。再者,從電信領域與半導體、科技業的結盟發展而論,我國未來將首先面臨AI穿戴裝置與行動通訊裝置,在跨境輸出、使用上的「標準化與合規」議題,值得大家進一步思考。